AI Acts nel Mondo: facciamo il punto della situazione (aggiornato a Dicembre 2025)

Userò questo articolo come collettore di notizie su come si stanno muovedo le legislazioni sulle AI nelle varie nazioni.

Altro articolo che secondo me vale la pena leggere e condividere, anche a chi non è interessato alla tecnologia.

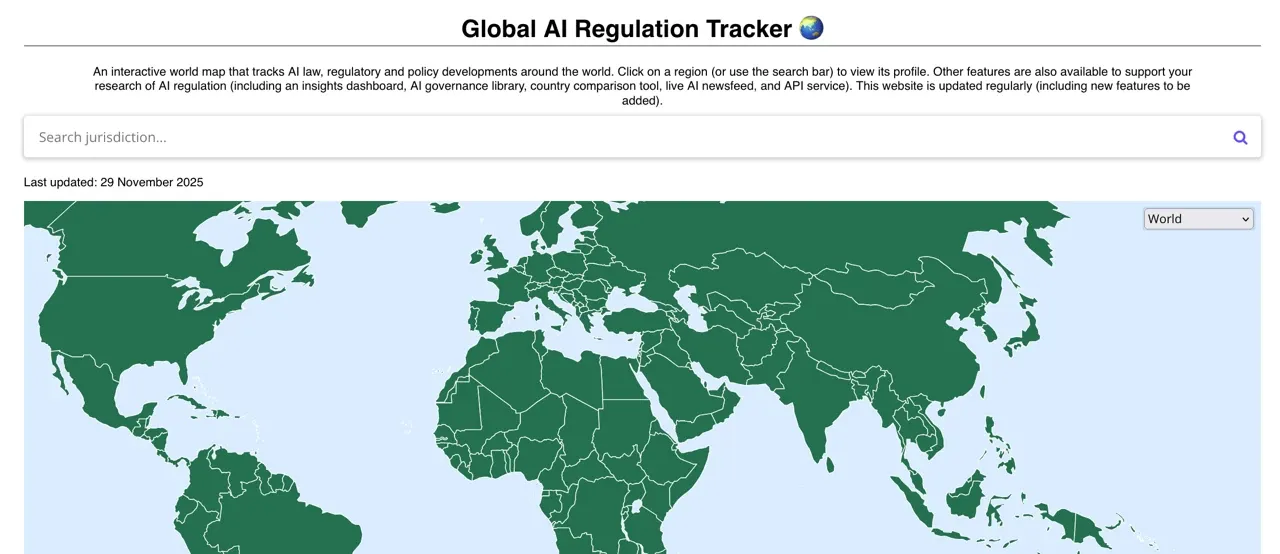

Il mio riferimento è Global AI Regulation Tracker di Raymond Sun. Il sito fa un lavoro davvero egregio.

AI Acts nel mondo

Status aggiornato degli AI Acts nel mondo (2025)

Questo documento sintetizza lo stato delle principali normative sull’intelligenza artificiale, mantenendo solo riferimenti a Wikipedia e siti istituzionali.

Unione Europea — AI Act

- Testo ufficiale del regolamento pubblicato come Regulation (EU) 2024/1689.

Fonte: https://artificialintelligenceact.eu/the-act/ - Entrato in vigore il 1° agosto 2024.

Fonte: https://artificialintelligenceact.eu/the-act/ - Obblighi completi per i sistemi high‑risk previsti tra 2026 e 2027, con possibile posticipo secondo la proposta della Commissione Europea “Digital Omnibus”.

Fonte istituzionale: https://digital-strategy.ec.europa.eu/en/library/digital-omnibus-ai-regulation-proposal - Obbligo di almeno un sandbox regolamentare per Stato membro entro il 2 agosto 2026.

Fonte: https://artificialintelligenceact.eu/

Stati Uniti — Stato federale e stati locali

- Non esiste una legge federale generale (“Federal AI Act”).

Fonte: https://en.wikipedia.org/wiki/Artificial_intelligence_regulation_in_the_United_States - Executive Order 14179 del 23 gennaio 2025 (revoca EO 14110).

Fonte: https://en.wikipedia.org/wiki/Executive_Order_14179 - California: Transparency in Frontier Artificial Intelligence Act (SB‑53).

Fonte: https://en.wikipedia.org/wiki/Transparency_in_Frontier_Artificial_Intelligence_Act

Cina — Normativa su AI generativa

- Interim Measures for the Management of Generative Artificial Intelligence Services (15 agosto 2023).

Fonte istituzionale: https://www.cac.gov.cn/ (Cyberspace Administration of China) - Standard nazionali sulla sicurezza dell’AI generativa in vigore dal 1 novembre 2025

(ad esempio: Security Specification for Generative AI Pre‑training & Fine‑tuning Data).

Non disponibile su Wikipedia, ma pubblicato tramite Ministero cinese degli Standard (SAC): http://www.sac.gov.cn/

Brasile — PL 2338/2023

- Disegno di legge sull’AI approvato dal Senato (dicembre 2024) ma non ancora legge: in attesa della Camera dei Deputati.

Fonte: https://en.wikipedia.org/wiki/Regulation_of_artificial_intelligence#Brazil

Note finali

Le normative AI stanno evolvendo rapidamente. L’UE resta il quadro regolatorio più strutturato a oggi, mentre USA e Cina procedono con approcci diversi (decentrato vs. standard tecnico). Il Brasile è in fase avanzata ma non conclusa.

Lista aggiornamenti

- 2 Settembre 2023 - Aggiunto l'interim report UK

- 14 Agosto 2023 - Aggiunto il link al Global AI Regulation Tracker di Raymond Sun

- 17 Luglio 2023 - insight su Cina.

- Aggiornamento su AI & Lavoro a New York

- 28 giugno 2023 - aggiornamenti su USA & Giappone

- 15 Giugno 2023 - prima stesura su europa

- 9 Dicembre 2023 - Accordo Raggiunto per l'europa, ti riporto i I principali elementi dell'accordo provvisorio AI ACT Europa Dicembre 2023

- Novembre 2025 - L'europa fa un passo indietro, rivalutando tutto il GDPR

AI Act in Giappone

Il Giappone invece propende per un approccio normativo sull'IA più rilassato rispetto all'UE, nel tentativo di stimolare la crescita economica e ottenere un vantaggio competitivo nelle tecnologie avanzate dei chip.

Un approccio giapponese più morbido potrebbe ostacolare gli sforzi dell'UE per stabilire le proprie regole come punto di riferimento globale, con requisiti quali la divulgazione da parte delle aziende di materiale protetto da copyright utilizzato per addestrare i sistemi di IA che generano contenuti come testo e grafica.

Il presidente del consiglio strategico sull'IA del governo giapponese, il Prof. Yutaka Matsuo dell'Università di Tokyo, ha definito le regole dell'UE "un po' troppo severe", affermando che è "quasi impossibile" specificare il materiale protetto da copyright utilizzato per il deep learning. Sarà...

Altra cosa interessante è che il Giappone vuole riconquistare il ruole di leader tecnologico e sta punatando moltissimo su Rapidus, Azienda di microchip.

Dell'importanza dei chip ne abbiamo parlato in varie newsletter.

Ai Act nel Regno Unito (UK)

Interim report

Gli UK sono la terza nazione a livello globale per quanto riguarda gli investimenti in AI a questo link si può leggere il loro Interim report.

Il governo del Regno Unito ha pubblicato un documento politico sull'intelligenza artificiale, ma gli autori di questo rapporto ritengono che l'approccio delineato non sia ambizioso abbastanza e rischi di restare indietro rispetto al ritmo di sviluppo dell'AI.

Il rapporto identifica dodici sfide chiave che devono essere affrontate per garantire che l'AI sia utilizzata in modo sicuro e responsabile. Queste sfide includono:

- Pregiudizio e discriminazione

- Privacy e sicurezza dei dati

- Sicurezza e affidabilità

- Trasparenza e spiegabilità

- Responsabilità e supervisione

- L'impatto sul lavoro e sulle competenze

- L'impatto sulla società e sulla cultura

- L'uso dell'AI in guerra

- L'esportazione della tecnologia AI

- La governance degli standard internazionali di AI

Il rapporto raccomanda che il governo del Regno Unito adotti un approccio più proattivo alla governance dell'AI, tra cui:

- L'introduzione di una specifica legislazione per l'AI

- Investimenti in ricerca e sviluppo

- Cooperazione internazionale

- Educazione pubblica sui rischi dell'AI

Il rapporto conclude che il Regno Unito ha una grande opportunità di essere un leader mondiale nell'AI, ma che questa opportunità è limitata nel tempo. Il governo deve agire ora per stabilire i giusti quadri di governance e garantire che il Regno Unito sia all'avanguardia della cooperazione internazionale sull'AI.

Ecco alcune delle parti più interessanti del rapporto:

- Il rapporto sottolinea l'importanza di affrontare il pregiudizio e la discriminazione nei sistemi di AI. I sistemi di AI possono essere addestrati su dati che riflettono i pregiudizi umani, il che può portare a questi pregiudizi a essere perpetuati nell'output del sistema. Ciò può avere un impatto negativo sulle persone che sono già marginalizzate o discriminate.

- Il rapporto sottolinea anche la necessità di privacy e sicurezza dei dati nei sistemi di AI. I sistemi di AI spesso raccolgono ed elaborano grandi quantità di dati personali, che potrebbero essere utilizzati per scopi dannosi se non sono adeguatamente protetti.

- Il rapporto sottolinea l'importanza di garantire che i sistemi di AI siano sicuri e affidabili. I sistemi di AI dovrebbero essere progettati per evitare di causare danni alle persone o alle proprietà.

- Il rapporto chiede una maggiore trasparenza e spiegabilità dei sistemi di AI. Ciò significa che le persone dovrebbero essere in grado di capire come funzionano i sistemi di AI e prendere decisioni. Ciò è importante per garantire che i sistemi di AI vengano utilizzati in modo equo e responsabile.

- Il rapporto raccomanda inoltre che il governo del Regno Unito investa in ricerca e sviluppo sull'AI. Ciò contribuirà a garantire che il Regno Unito rimanga all'avanguardia dell'innovazione dell'AI.

- Il rapporto chiede inoltre al governo del Regno Unito di costruire la cooperazione internazionale sull'AI. Ciò è importante per garantire che l'AI venga utilizzata in modo responsabile ed etico.

Nel complesso, il rapporto fornisce una panoramica completa delle sfide e delle opportunità dell'AI. È una risorsa preziosa per i decisori politici, le imprese e gli individui interessati a garantire che l'AI venga utilizzata in modo sicuro e responsabile.

Member discussion